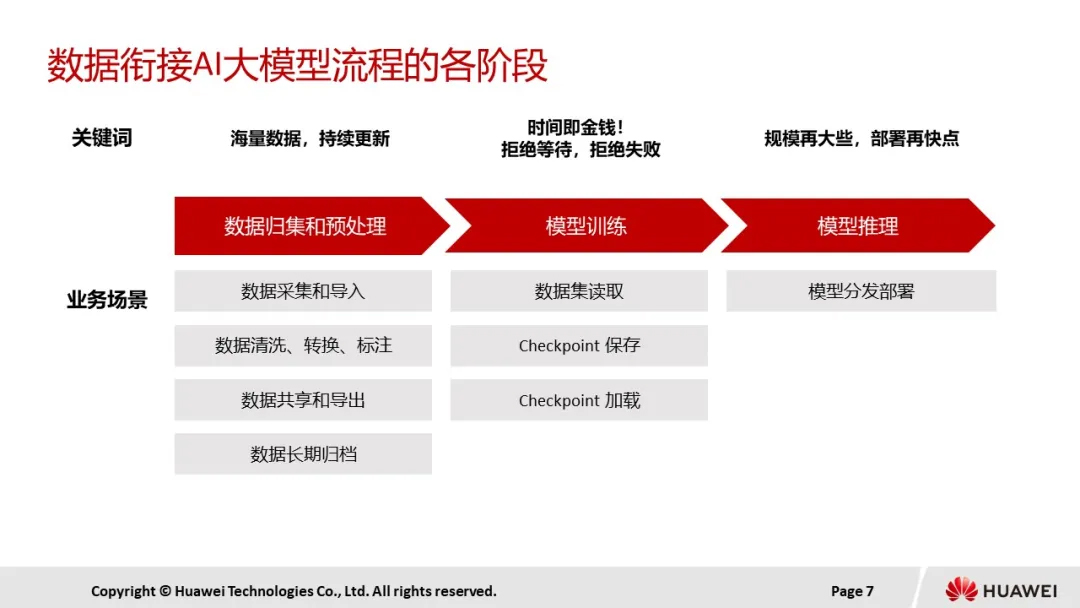

在AI大模型从训练至推理的每一个关键环节,存储都扮演着不可或缺的角色。

数据归集与预处理阶段,面对来源广泛、形式多样的数据,存储系统需要具备全局统一命名空间与原生无损多协议互通的特性,确保数据的无缝整合与高效流通。

同时,极致的稳定性和可靠性更是存储系统的基石,为数据安全筑起坚不可摧的防线。进入模型训练阶段,为了确保数据集能够被快速读取,减少等待时间,存储需要具备数千节点的横向扩展能力。

这样的能力可以支撑亿级文件列表的获取,满足大规模数据训练的需求,为模型的高效训练提供强大的保障。

当模型发布并投入推理阶段后,存储系统的高并发、高吞吐、高效率等特性更是显得尤为重要。它能够确保在推理过程中,数据能够迅速、准确地被处理,从而满足AI应用对于实时性与准确性的严苛要求。

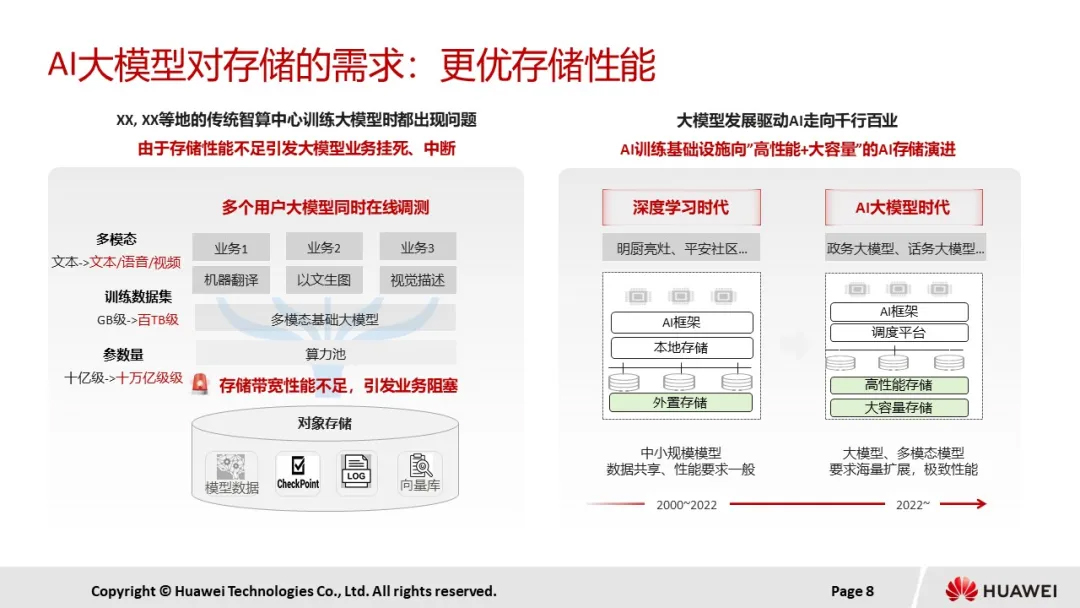

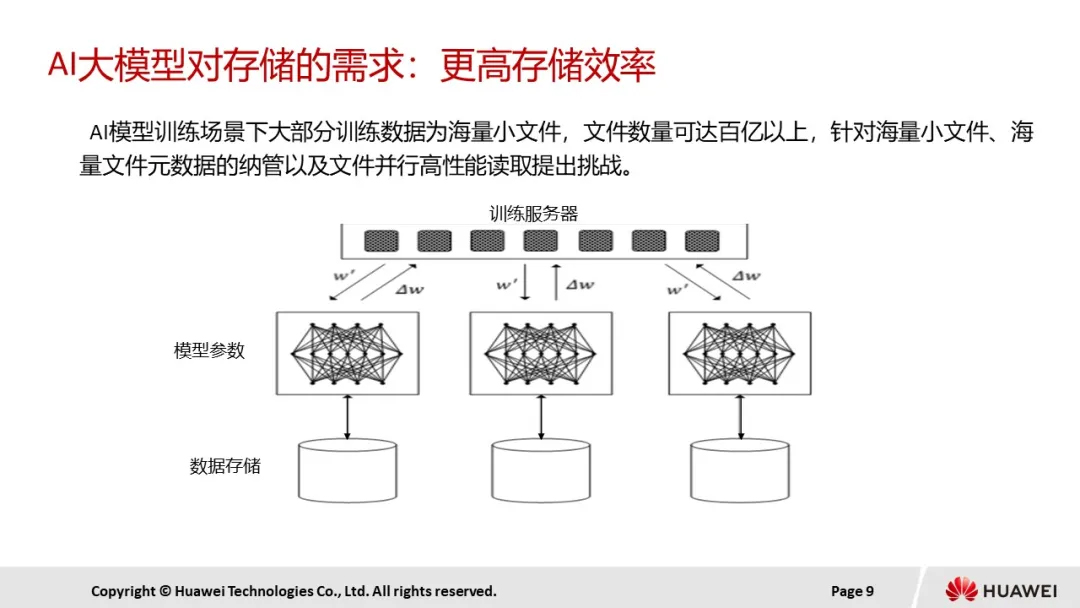

接下来,我们具体从两个方面来探讨AI大模型对存储的需求。

首先大模型需要更大的存储容量,从文本到多模态,数据增长巨大,数据规模往往都达到了PB级,随着模型规模和原始数据的增加,数据规模也会增长,为了应对海量的数据存储问题,需要大模型存储具备良好的扩展性。

大模型存储采用的分布式架构,通过横向扩展增加存储容量和性能,一方面可以满足存储容量的持续增加,另一方面还能满足模型训练对高带宽、高IO存储的需求,从而充分发挥计算资源的算力,保障计算资源不浪费。

其次,大模型需要更优的存储性能,大模型训练过程中需要处理海量数据,包括数据集的加载、模型参数的保存与恢复等,这些操作都依赖存储系统的性能。数据集加载阶段,需要将大量数据从存储系统加载到内存中。

如果存储系统性能不足,数据加载速度缓慢,会直接影响训练的启动效率。模型训练过程中,模型参数需要定期保存,以便在训练中断时能够快速恢复。这要求存储系统具备高吞吐量和低延迟,以确保参数的快速写入和读取。对此,基础设施层也从“本地盘”向”高性能+大容量”的AI存储演进。