2025-08-25作者:数据存算生态大会

在数字化与 AI 深度融合的 2025 年,智能算力中心已成为金融、医疗、科研等领域的 “数字底座”。

但随着算力规模突破百万 PFlops、AI 大模型参数迈入万亿级,运维管理正面临三大核心痛点:算力资源利用率不足 30% 、故障排查耗时超 24 小时 、大模型全周期管理缺失 。

为此,我们整合 GPU 池化、云原生、智能监控等前沿技术,打造出一套 “资源 - 运行 - 管理 - 优化” 全链路运维方案,助力企业破解算力运维难题。

一、行业痛点:智能算力中心运维的三大挑战

在深入方案前,先明确当前运维管理的核心困境,为技术落地提供现实依据:

算力资源浪费严重:传统 GPU 固定分配模式下,科研、AI 训练等场景存在 “忙时算力不足,闲时资源闲置” 问题,部分企业 GPU 利用率甚至低于 20%。

系统运维效率低下:算力中心涉及数千台服务器、PB 级存储,传统人工监控难以覆盖全链路,故障平均排查时间(MTTR)长达 1-3 天。

大模型管理无序:AI 大模型训练周期长、版本多,缺乏统一管理平台导致模型迭代混乱,推理服务稳定性难以保障。

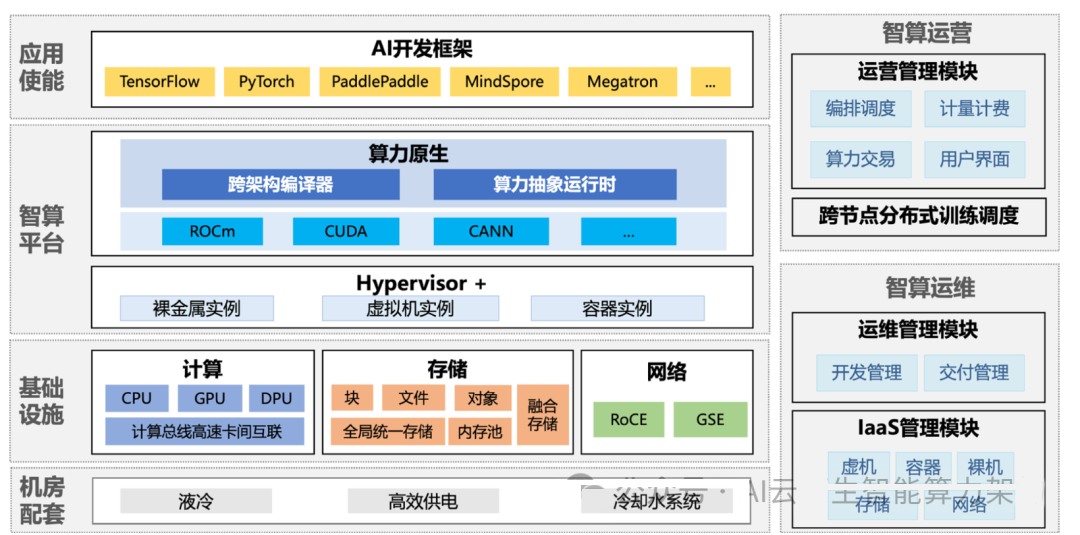

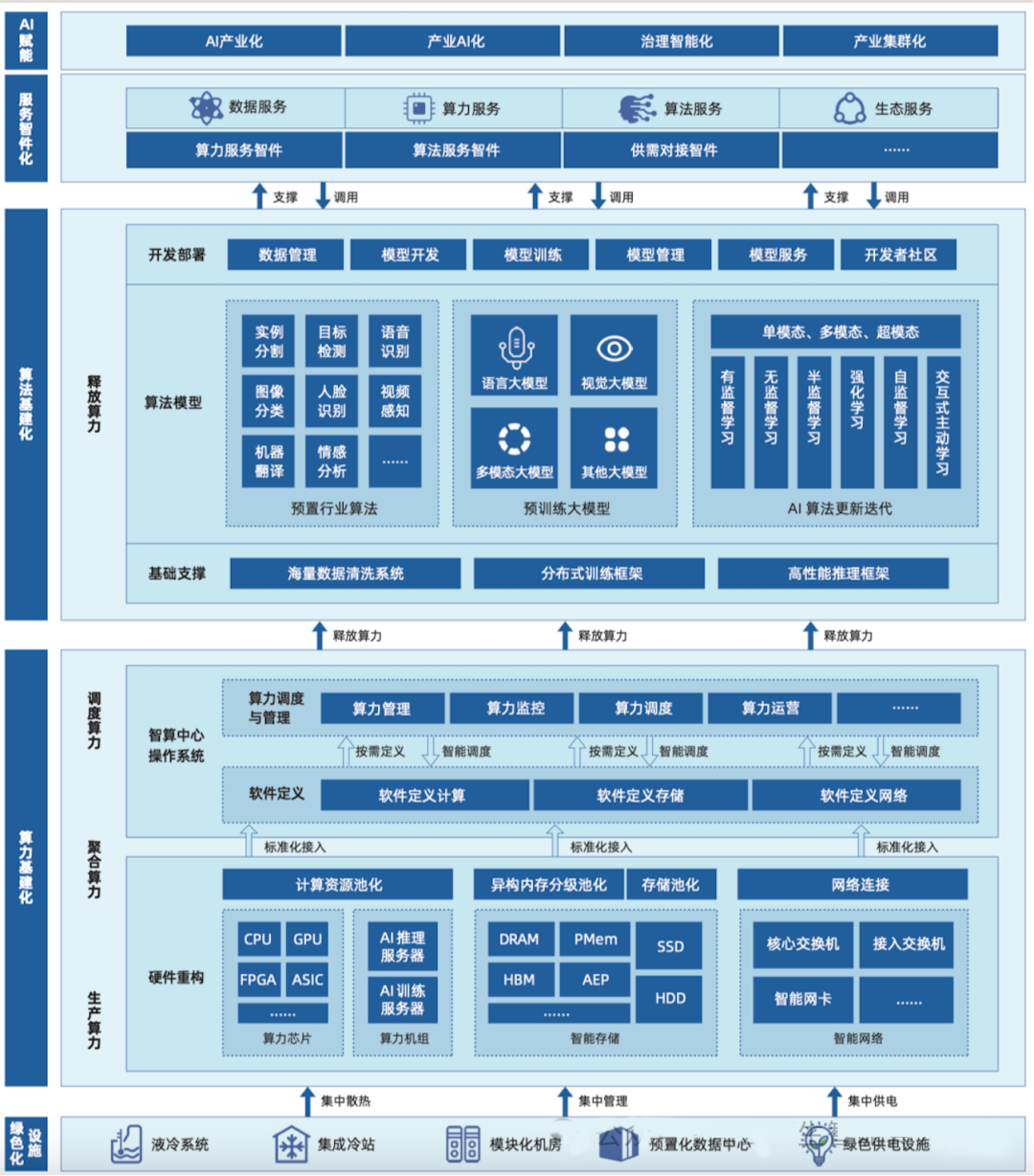

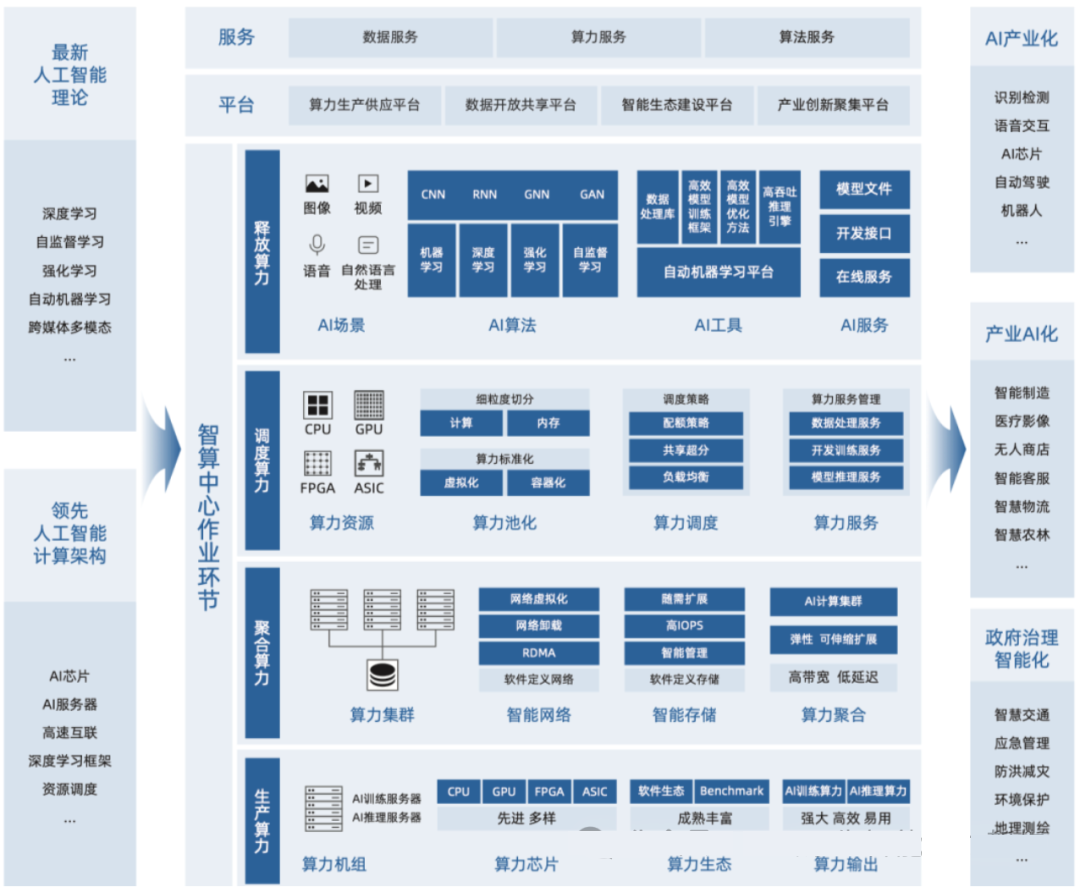

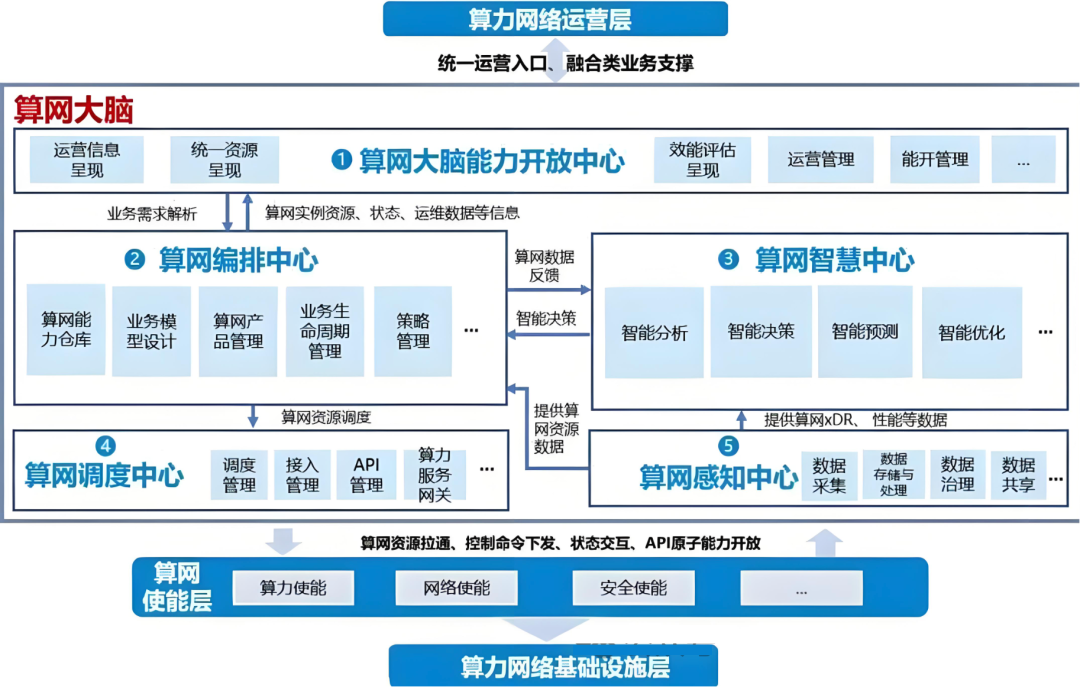

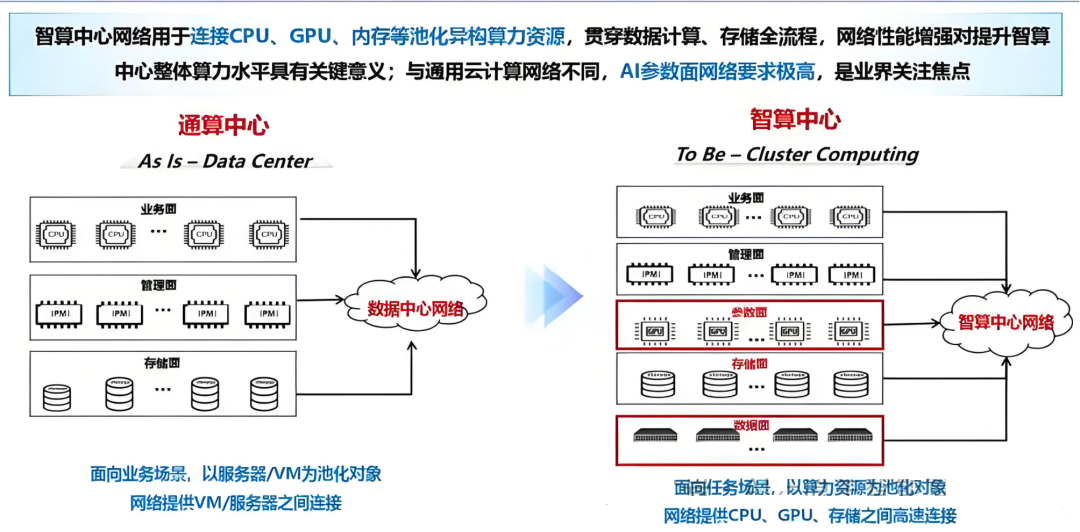

智能算力中心建设架构

二、核心技术方案:构建 “四层一体” 运维体系

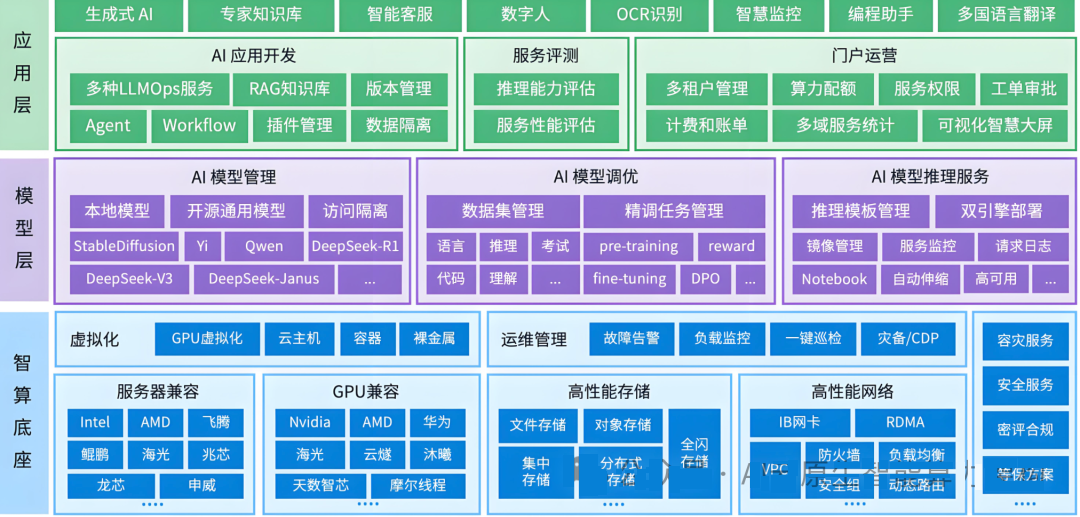

针对上述痛点,方案从 “资源层 - 运行层 - 监控层 - 应用层” 四个维度,实现算力中心的高效运维,各层级既独立解决专项问题,又相互协同形成闭环。

智能算力中心网络调度结构

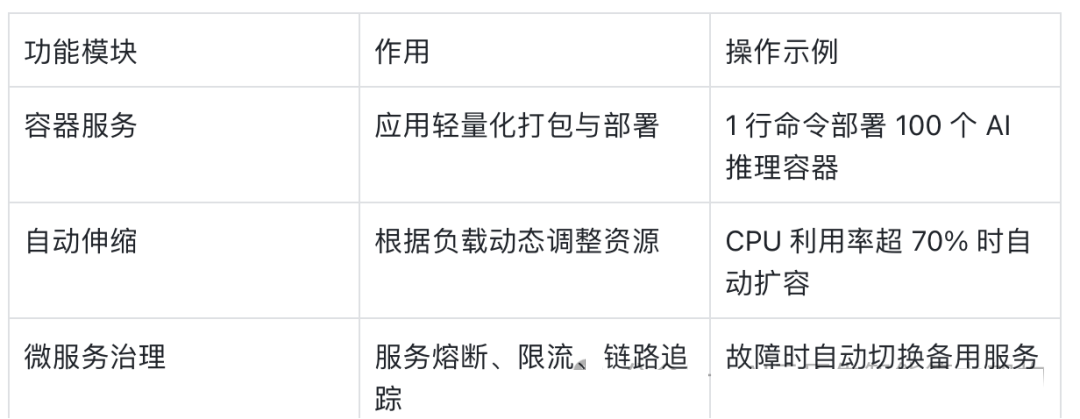

(二)运行层:云原生平台 —— 让应用 “敏捷伸缩”

基于 Kubernetes 生态构建的云原生平台,是算力中心的 “运行底座”,实现应用全生命周期自动化管理。

核心能力拆解

企业实践(移动云 CNP 平台)某电商平台在 “618” 期间,通过 CNP 平台实现 3000 + 容器的分钟级部署,峰值算力支撑提升 5 倍;内置研发效能工具,可将 AI 应用从代码提交到上线的周期缩短至 1 小时。

(三)监控层:“监控 - 日志 - 告警” 三位一体 —— 让问题 “无处遁形”

监控层是算力中心的 “神经中枢”,通过全链路数据采集与智能分析,实现故障的 “早发现、早定位、早解决”。

监控系统:实时掌握运行状态覆盖范围:从硬件(服务器、GPU、存储)到软件(容器、应用、网络)。

关键指标:GPU 算力利用率、内存带宽、网络丢包率、容器健康状态。

可视化工具:支持 3D 机房视图、实时算力热力图,运维人员可直观查看全局状态。

日志系统:追溯问题根源采用 ELK Stack(Elasticsearch+Logstash+Kibana)架构,实现日志的集中存储与检索。

智能分析功能:自动识别异常日志(如 GPU 驱动报错),并关联相关任务与资源信息,定位时间从 24 小时缩短至 10 分钟。

告警系统:主动防范风险青云科技方案亮点:1000 + 故障特征库,支持秒级故障识别(如 GPU 温度超 85℃、网络延迟突增)。

多级告警策略:一般告警(邮件通知)、严重告警(短信 + 企微推送)、紧急告警(电话通知)。

自愈能力:简单故障(如容器崩溃)可自动重启,复杂故障自动隔离故障节点并转移任务。

(四)应用层:AI 大模型管理平台 —— 让模型 “有序迭代”

针对 AI 大模型的全生命周期管理需求,平台提供从训练到推理的一站式支持。

核心功能流程模型训练:自动分配 GPU 资源,监控训练进度(损失值、准确率),支持断点续训。

模型存储:版本化管理模型文件,支持一键回滚历史版本。

推理部署:自动优化模型(如量化、剪枝),并部署为 API 服务,支持每秒 1000 + 请求。

效果评估:实时监测推理精度与响应时间,精度下降超 5% 时自动触发重新训练。

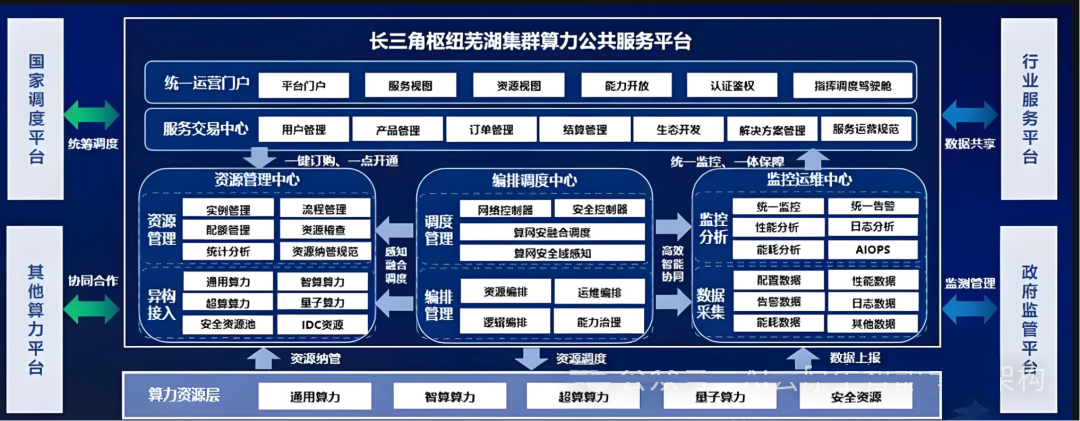

区域级算力中心调度架构图

操作步骤详述模型训练操作:

数据准备:收集、清洗、标注训练数据,按 8:1:1 比例划分为训练集、验证集、测试集,存储于分布式文件系统,如 Ceph,确保数据高可用与读写性能。

环境配置:在训练节点搭建适配模型框架的运行环境,如 PyTorch、TensorFlow,安装对应版本依赖库,保障训练流畅运行。

任务提交:通过管理平台界面或命令行工具,提交训练任务,指定数据集路径、模型架构、训练超参数(学习率、迭代次数等),平台自动匹配并分配 GPU 资源。

过程监控:利用 TensorBoard 等可视化工具,实时查看训练过程中的损失值、准确率曲线,发现异常(如损失值飙升、准确率停滞)及时暂停任务,调整超参数或检查数据质量。

多云算力中心调度架构图

模型存储管理:

版本标记:每次训练完成,平台自动为模型打上版本号,格式为 “vX.Y.Z”,X 代表重大版本更新,Y 为功能迭代,Z 为修复补丁,同时记录训练时间、数据版本、超参数等关键信息。

存储架构:采用对象存储(如 MinIO)保存模型文件,配合数据库(如 MySQL)记录模型元数据,方便快速检索与管理。

回滚操作:若新模型效果不佳,在管理平台选定目标历史版本,点击 “回滚” 按钮,平台自动恢复对应模型文件与环境配置,重新上线服务。

通算中心和智算中心网络架构

推理部署流程:

模型优化:针对推理场景,使用模型压缩工具(如 NVIDIA TensorRT)对训练好的模型进行量化(如将 32 位浮点数转换为 16 位或 8 位)、剪枝(去除冗余连接)操作,提升推理速度、降低资源消耗。

服务部署:将优化后的模型部署为 RESTful API 服务,借助容器化技术(如 Docker)打包,通过 Kubernetes 编排调度,部署至推理集群,确保服务高并发与稳定性。

负载均衡:配置 Nginx 等负载均衡器,按权重、轮询等策略将推理请求分发至各推理节点,保障服务响应效率。

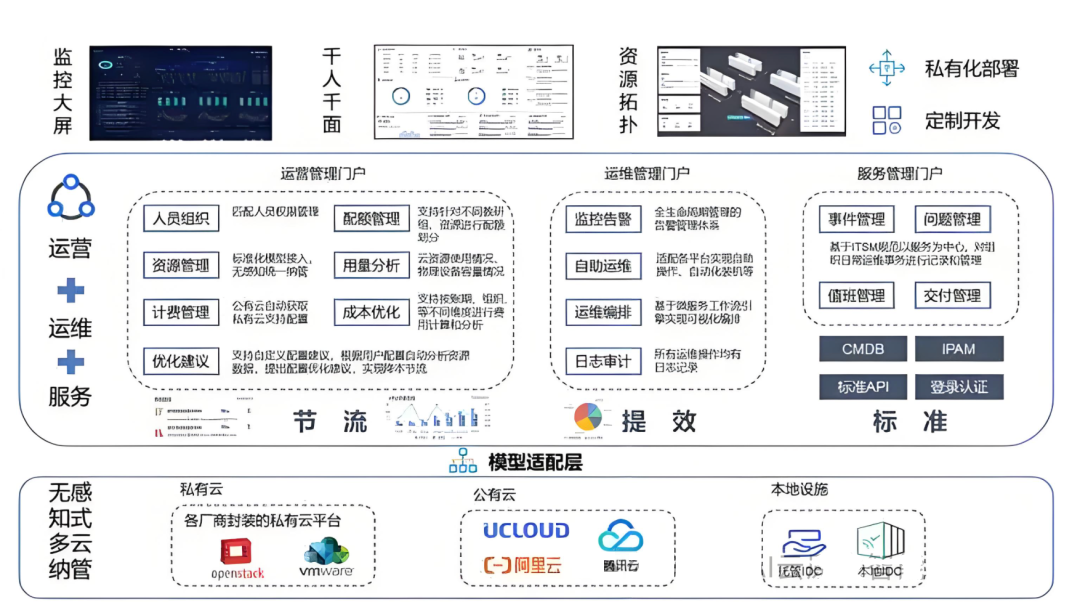

AI大模型架构图

效果评估与优化:

指标监控:通过 Prometheus+Grafana 搭建监控体系,实时采集推理精度(准确率、召回率等)、响应时间、吞吐量等指标数据,绘制趋势图。

阈值设定:依据业务需求,设置精度下降阈值(如 5%)、响应时间上限(如 500 毫秒),一旦指标触及阈值,平台自动发出告警。

优化触发:收到精度告警后,自动启动模型重新训练流程,使用最新标注数据微调模型;若响应时间过长,分析瓶颈(如 GPU 算力不足、网络延迟),针对性扩容资源或优化网络。企业价值某 AI 公司通过该平台,将大模型训练周期从 15 天缩短至 7 天,推理成本降低 40%。支持多模型并行部署(如 ChatGPT 类模型 + 图像生成模型),资源共享效率提升 30%。

三、方案价值与落地建议

(一)三大核心价值

降本增效:GPU 利用率提升 50%+,运维人力成本降低 40%;

稳定可靠:故障 MTTR 缩短至 1 小时内,系统可用性达 99.99%。

敏捷创新:AI 应用上线周期缩短 70%,助力业务快速迭代。

(二)落地注意事项分步实施:

先部署 GPU 池化与监控系统,再推进云原生与大模型平台。

团队适配:开展 Kubernetes、GPU 管理等技能培训,确保运维团队能熟练操作。

持续优化:定期分析运维数据(如资源利用率、故障类型),调整策略(如优化告警阈值、调整算力分配规则)。

2025 年的智能算力运维,已从 “被动响应” 转向 “主动管理”。

通过上述 “四层一体” 解决方案,企业不仅能破解当前算力管理难题,更能为未来更大规模的算力需求(如量子计算融合、AI 大模型产业化)奠定基础。如果您想了解某一模块的详细技术文档或落地案例,欢迎在评论区留言!

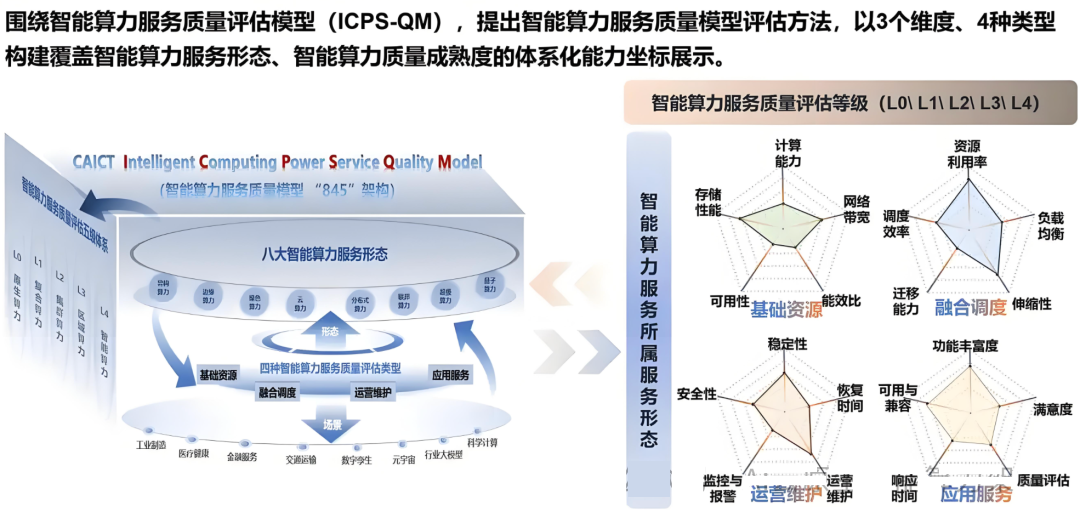

智能算力中心服务质量评估模型